Dans la tendance de Deepseek R1 et o3 d’OpenAI, IBM a présenté un modèle de raisonnement dans la version 3.2 de sa famille de LLM Granite. Big blue dévoile par ailleurs des modèles de reconnaissance d’image et d’analyse prédictive.

Depuis quelques mois, le marché est en ébullition pour les capacités de raisonnement des LLM. L’arrivée fulgurante de Deepseek et son modèle R1 a mis en lumière cette orientation. Depuis, des sociétés comme Anthropic avec Claude 3.7 Sonnet suivent le mouvement. C’est aussi le cas pour IBM qui vient de présenter la version 3.2 de Granite, une gamme de LLM open source. Parmi eux, certains sont dotés de capacité renforcée de raisonnement, d’autres proposent de la reconnaissance d’image (computer vision) dédié aux documents et de l’analyse prédictive.

Un modèle avec un raisonnement conditionnel

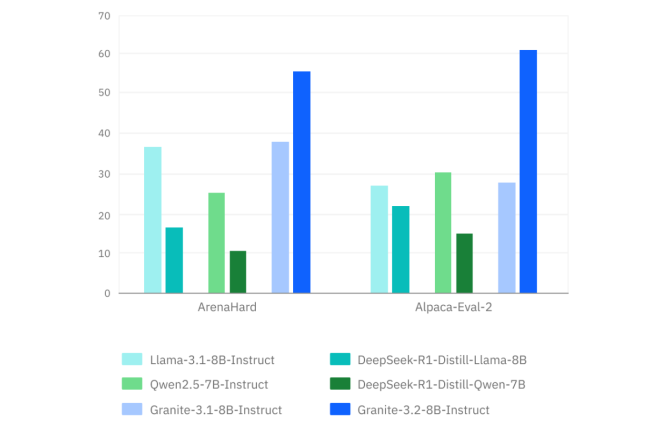

Concernant le raisonnement, IBM a une approche pragmatique en misant sur « un raisonnement conditionnel ». Cela signifie que cette capacité peut être activée ou pas selon la complexité de la tâche sur les modèles Instruct 2B et 8B. Selon big blue, les requêtes mobilisant uniquement de la connaissance ne nécessitent pas une réflexion poussée et pourrait même nuire à la performance de la réponse. IBM note par exemple que Deepseek R1 met 50,9 secondes pour répondre à la simple question “Où est Rome ?” En revanche, pour des tâches comme les mathématiques ou l’ingénierie logicielle, le modèle peut décomposer les problèmes, avoir de meilleurs jugements et recommander des solutions plus pertinentes.

Cette approche d’activation dynamique des capacités de raisonnement du modèle apporte selon IBM plus de flexibilité pour les développeurs pour trouver un équilibre entre la rapidité et la profondeur d’analyse. La technique repose sur une méthode développée par Red Hat (filiale d’IBM) nommée « filtre à particules » où de nombreux raisonnements sont menés simultanément. Le filtre élague les approches les moins efficaces et se concentrer sur celles qui donnent de meilleurs résultats. Ainsi, au lieu de se concentrer sur un raisonnement, il existe plusieurs analyses pour résoudre un problème. Par ailleurs à la différence de Deepseek, IBM ne sépare pas le modèle de fondation et celui de raisonnement, le raisonnement est activable directement dans le LLM de fondation.

L’analyse d’image pour les documents et le prédictif gonflé à l’IA

Dans la famille Granite 3.2, IBM propose également un modèle dédié à l’analyse d’image (computer vision) pour répondre à une problématique spécifique d’entreprise, la gestion des documents scannés et archivés. Big Blue cible notamment les institutions financières qui disposent d’une grande quantité de documents scannés, mais inexploités. Le LLM (d’une taille légère avec 2 milliards de paramètres) se focalise donc sur la reconnaissance d’image et de texte dans les documents (tableaux, graphiques, formules, figures,…).

Enfin le dernier modèle de Granite 3.2 s’attaque à l’analyse prédictive, traditionnellement basé sur le machine learning. IBM essaye d’insuffler d’autres techniques d’IA dans ce domaine. La société a commencé avec les modèles TTM (tiny time mixers), de tailles minimes (entre 1 à 5 millions de paramètres) et très spécialisée. Aujourd’hui, elle affine ses modèles avec des longueurs de contexte et des horizons de prévision variés. Ainsi, les anciens modèles offraient des longueurs de contexte de 1536, 1024 ou 512, les derniers proposent des contextes plus courts allant de 512 à 52 adaptés aux prévisions journalières et hebdomadaires. Pour IBM, ces évolutions répondent aux besoins critiques des entreprises en matière de prévisions financières, de planification de la maintenance des équipements et de détection des anomalies. Pour tester l’ensembles des modèles, IBM les met à disposition dans Watsonx.ai, Hugging Face, Ollama, LMStudio et Replicate.

Leave A Comment