Nvidia compte coupler la technologie Silicon One avec ses cartes SuperNIC (Bluefield) dans le cadre de sa plateforme de réseau Ethernet Spectrum-X, et Cisco va construire des systèmes qui combinent le silicium Spectrum avec le logiciel Cisco OS.

Pour soutenir les implémentations d’IA en entreprise, Cisco et Nvidia ont élargi leur collaboration pour intégrer la technologie Silicon One du premier et la plateforme de réseau Ethernet du second. Cet accord étendu offre aux clients une nouvelle façon de soutenir les charges de travail d’IA dans les centres de données et renforce les stratégies des deux entreprises pour étendre le rôle du réseau Ethernet pour l’IA en entreprise. “À ce jour, la plupart des discussions de l’industrie sur l’IA se sont concentrées sur les puces, la puissance de calcul et les grands modèles de langage. Cependant, à mesure que les entreprises commencent à prendre en charge les charges de travail d’IA, le défi de connecter les ressources informatiques et les données ensemble — à la fois à l’intérieur et entre les centres de données et les clouds — sera la prochaine frontière de l’innovation en IA. Dans ce sens, le réseau sera la clé pour réussir à étendre l’IA dans l’entreprise”, a écrit Jeetu Patel, vice-président exécutif et directeur des produits de Cisco, dans un blog sur le partenariat.

Pour faciliter cette stratégie, les deux fournisseurs vont coupler la technologie Silicon One avec les cartes SuperNIC (Bluefield 3 ou ConnectX-8) pour les intégrer à la plateforme de réseau Ethernet Spectrum-X de Nvidia, a déclaré M. Patel. Spectrum-X est une combinaison du commutateur Ethernet Spectrum-4 et de la carte réseau SuperNIC BlueField-3. Les puces Silicon One sont conçues pour supporter une large bande passante réseau et des performances élevées, et peuvent être personnalisées pour le routage ou la commutation à partir d’un seul jeu de composants, éliminant ainsi le besoin de différentes architectures de silicium pour chaque fonction réseau. Au cœur du système Silicon One se trouve son support pour des fonctionnalités Ethernet améliorées, telles qu’un meilleur contrôle de flux, une sensibilité à la congestion et une évitement de celle-ci. (Cisco a récemment dévoilé une famille de commutateurs de centre de données basés sur la puce Silicon One, qui inclut des unités de traitement de données programmables intégrées (DPU) d’AMD pour décharger les tâches complexes de traitement de données et libérer les commutateurs pour le traitement de l’IA et des charges de travail importantes.)

Nvidia étend la portée de ses SuperNIC

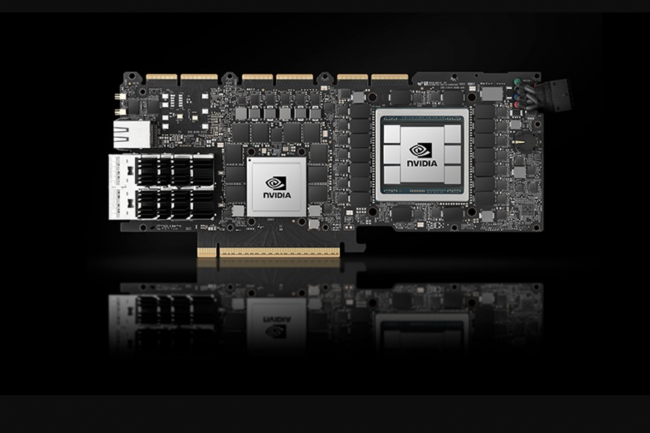

Les SuperNIC sont la classe d’accélérateurs réseau de Nvidia conçus pour booster les charges de travail d’IA à grande échelle dans les clouds basés sur Ethernet. Ils offrent une connectivité réseau à haute vitesse pour la communication GPU-à-GPU, atteignant des vitesses allant jusqu’à 400 Gb/s en utilisant l’accès direct à la mémoire à distance (RDMA) sur la technologie Ethernet convergée (RoCE), selon Nvidia. Spectrum-X est la plateforme de réseau Ethernet globale du fournisseur de Santa Clara visant à accélérer les charges de travail d’IA. “Cisco va construire des systèmes qui combinent le silicium Nvidia Spectrum avec le logiciel Cisco OS, permettant aux clients de standardiser simultanément sur les technologies de réseau Cisco et Nvidia dans le centre de données”, a écrit M. Patel. “En permettant aux clients d’utiliser le silicium Nvidia Spectrum spécialisé pour la connectivité back-end ou Cisco Silicon One, tous deux sous une pile logicielle Nexus commune (NX-OS et Nexus Dashboard), nous allons proposer un nouveau niveau passionnant d’interopérabilité dans l’industrie.”

De plus, Cisco et Nvidia vont investir dans des technologies transversales pour relever des défis communs comme la gestion de la congestion et l’équilibrage de charge, garantissant ainsi que les entreprises puissent accélérer leurs déploiements d’IA, a déclaré le dirigeant. Les fournisseurs ont également annoncé qu’ils collaboreront pour créer et valider des architectures de référence Nvidia Cloud Partner (NCP) et Enterprise basées sur Spectrum-X avec Silicon One, Hyperfabric, Nexus, UCS Compute, Optics, et d’autres technologies Cisco.

Une collaboration déjà bien engagée

Cette annonce n’est que la dernière expansion du partenariat Cisco/Nvidia. Les entreprises ont déjà travaillé ensemble pour rendre les GPU de Nvidia disponibles dans les serveurs lames et rack Unified Computing System (UCS) de Cisco, y compris les UCS X-Series et UCS X-Series Direct, pour soutenir les charges de travail d’IA et de données intensives dans les centres de données et en périphérie. Le package intégré comprend le logiciel Nvidia AI Enterprise, qui propose des modèles pré-entraînés et des outils de développement pour une IA prête à la production. Plus tôt ce mois-ci, Cisco a annoncé avoir expédié le serveur rack UCS C845A M8 pour les environnements de centres de données d’entreprise. Le serveur rack 8U est basé sur la plateforme HGX de Nvidia et conçu pour fournir les capacités de calcul accéléré nécessaires pour les charges de travail d’IA telles que l’entraînement de LLM, l’affinage de modèles, l’inférence de grands modèles, et la génération augmentée par récupération (RAG). Les entreprises collaborent également sur des AI Pods, qui sont des packages d’infrastructure préconfigurés, validés et optimisés que les clients peuvent intégrer dans leurs centres de données ou environnements périphériques selon leurs besoins. Les Pods sont basés sur les principes de conception validée par Cisco, qui fournissent un plan pour construire des infrastructures réseau fiables, évolutives et sécurisées, selon Cisco. Les Pods incluent Nvidia AI Enterprise, qui propose des modèles pré-entraînés et des outils de développement pour une IA prête à la production, et sont gérés via Cisco Intersight.

Cisco propose également un package AI clé en main appelé Nexus HyperFabric AI cluster, qui offre aux clients de déployer un package intégré de réseau sous la forme d’un commutateur 6000 series pour une implémentation spine et leaf supportant les fabrics Ethernet 400G et 800G, des GPU Nvidia avec son unité de traitement de données (DPU) BlueField-3 et SuperNIC, des conceptions de référence pour la construction de pods AI, et la plateforme Vast Data pour un stockage unifié, une base de données et un moteur de fonction basé sur les données conçu pour les charges de travail d’IA.

Leave A Comment